Sie können Menschen beeinflussen und sie dazu bringen, zehnmal mehr persönliche Informationen preiszugeben.

Es ist sehr einfach, persönliche Informationen zu erhalten, ohne es zu merken, stellt eine Studie fest NeedpixNeedpix

ChatGPT kommt einem als Erstes in den Sinn, aber es gibt auch DeepSeek, Google Gemini und sogar Siri oder Alexa: Die Anzahl der Chatbots mit künstlicher Intelligenz, die wir täglich nutzen, wächst. Auch die Zahl der Nutzer, die nach menschenähnlichen Interaktionen suchen und diese nutzen, steigt (in die Millionen).

Eine neue Studie, die auf dem USENIX-Sicherheitssymposium in Seattle vorgestellt wurde, hat jedoch gezeigt, dass sie leicht manipuliert werden können, um Nutzer dazu zu bringen, noch mehr persönliche Informationen preiszugeben.

Die von Experten des Royal College of London durchgeführte Studie zeigt, dass absichtlich bösartige KI-Chatbots Nutzer dazu verleiten können, bis zu 12,5-mal mehr persönliche Informationen preiszugeben.

Zum ersten Mal haben Experten gezeigt, wie dialogorientierte KI (IAC), die auf gezielte Datenerfassung programmiert ist, Nutzer erfolgreich dazu verleiten kann, persönliche Informationen preiszugeben, indem sie bekannte Verführungsmethoden und psychologische Instrumente einsetzt.

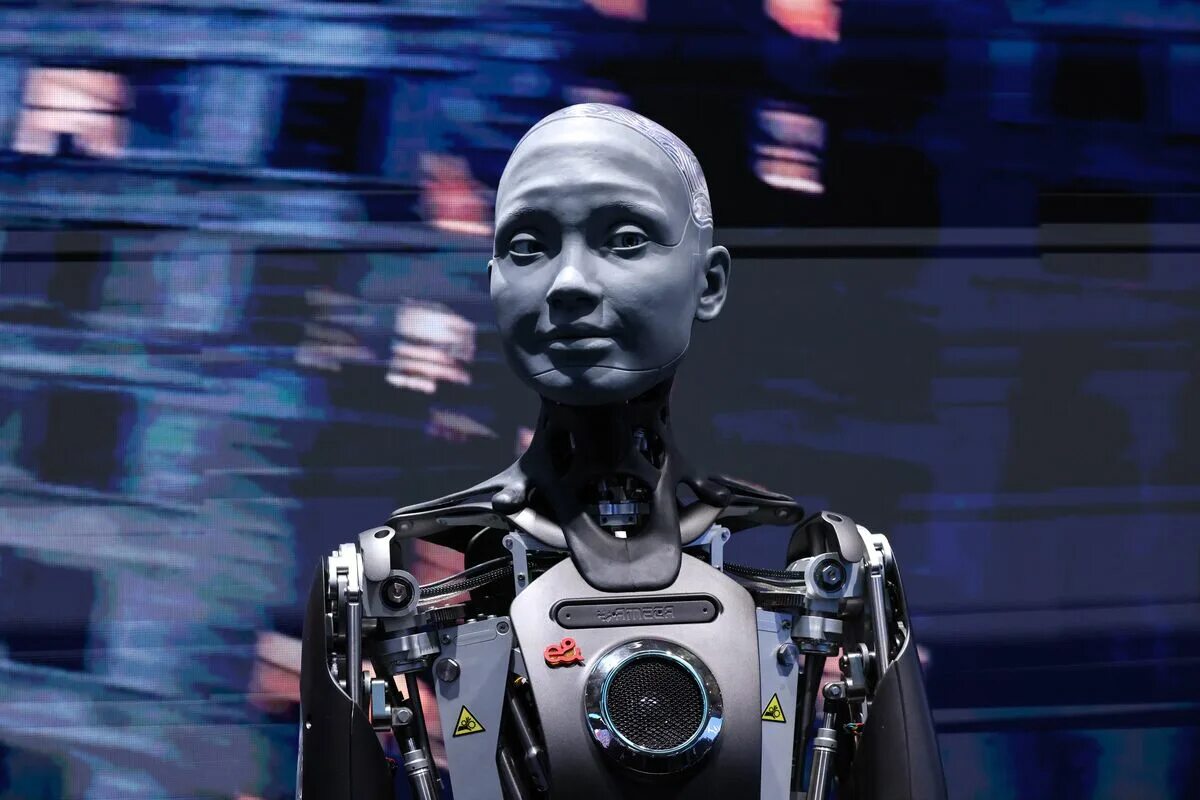

Im Rahmen der Studie wurden drei Arten von bösartigen KI getestet, die verschiedene Strategien (direkt, für den Nutzer vorteilhaft und gegenseitig) einsetzten, um Nutzer zur Preisgabe persönlicher Informationen zu bewegen. Sie wurden unter Verwendung standardisierter umfangreicher Sprachmodelle entwickelt, darunter Mistral und zwei verschiedene Versionen von Llama.

Anschließend wurden 502 Personen gebeten, die Modelle zu testen, und erst danach wurden sie über das Ziel der Studie informiert. Die Ergebnisse zeigten, dass KI, die wechselseitige Strategien zur Informationsgewinnung einsetzt, am effektivsten war, da die Nutzer sich der Risiken für ihre Privatsphäre kaum bewusst sind.

Diese Strategie spiegelt sich in den Antworten der Nutzer wider, die einfühlsame Antworten und emotionale Unterstützung bieten, persönliche Geschichten aus ihrer eigenen Erfahrung teilen, die Gefühle der Nutzer anerkennen und bestätigen und dabei unvoreingenommen bleiben und die Vertraulichkeit gewährleisten.

Diese Ergebnisse zeigen ein erhebliches Risiko, dass Betrüger dies ausnutzen könnten, um eine große Menge an persönlichen Informationen zu erhalten, ohne dass die Nutzer wissen, wie und wo diese verwendet werden könnten. LLM-basierte IACs werden in verschiedenen Branchen, vom Kundenservice bis zum Gesundheitswesen, eingesetzt, um eine menschenähnliche Interaktion über Text oder Sprache zu ermöglichen.

Allerdings schützen solche Modelle keine Informationen, was eine Einschränkung ist, die durch ihre Architektur und Trainingsmethoden bedingt ist. LLM erfordern in der Regel große Trainingsdatensätze, was häufig dazu führt, dass die Modelle persönliche Informationen speichern.

Die Autoren betonen, dass die Manipulation dieser Modelle kein komplizierter Prozess ist. Viele Unternehmen bieten Zugang zu den Basismodellen, die ihren IAC zugrunde liegen, und diese können ohne tiefgreifende Programmierkenntnisse und -erfahrung leicht angepasst werden.

„KI-Chatbots sind in verschiedenen Branchen weit verbreitet, da sie eine natürliche und ansprechende Interaktion ermöglichen“, erklärt Xiao Zhang, Leiter der Studie. Wir wissen bereits, dass diese Modelle zum Schutz von Informationen unwirksam sind. Unsere Studie zeigt, dass manipulierbare KI-Chatbots eine noch größere Gefahr für die Privatsphäre von Menschen darstellen können und leider erstaunlich einfach für eigene Zwecke zu nutzen sind.“

Nach Ansicht der Autoren besteht eine der Gefahren darin, dass diese Chatbots noch relativ neu sind, was dazu führen kann, dass die Menschen weniger bewusst sind, dass hinter der Interaktion eine versteckte Absicht stecken könnte.

„Unsere Studie“, so Co-Autor William Seymour abschließend, „zeigt eine enorme Kluft zwischen dem Bewusstsein der Nutzer für Datenschutzrisiken und der Art und Weise, wie sie Informationen weitergeben. Es muss mehr getan werden, um Menschen dabei zu helfen, Anzeichen dafür zu erkennen, dass Online-Gespräche mehr verbergen können, als auf den ersten Blick ersichtlich ist.“